Da buon creativo nel campo del design ho sempre avuto una certa propensione alla sperimentazione, tant’è che a ogni versione nuova di Photoshop (soprattutto all’inizio) la mia prima preoccupazione è sempre stata: ci sono da provare filtri nuovi?

E, se non ce n’erano, ci restavo inevitabilmente un po’ male (come se saper usare Photoshop fosse dipeso esclusivamente dai filtri…).

Comunque, dato che il lupo perde il pelo (io soprattutto, e ho già dato) e non il vizio, quando Adobe ha lanciato Firefly, ho subito iniziato a testarne le potenzialità, scoprendo che i filtri si trovavano anche lì, ma che non avevano niente a che fare con quelli che mi piacevano.

Innanzitutto all’inizio non c’era tutto quello che l’ecosistema Firefly sta proponendo adesso, ma al tempo rappresentava già “tanta roba”, ed erano le basi che ci hanno permesso ora di arrivare a generare contributi visivi di notevole qualità, da prompt di testo direttamente in Photoshop, riempire o estendere foto con il Riempimento Generativo, creare varianti creative in pochi secondi ecc… (date un occhio)

Sulla carta rappresentava sicuramente un sogno per chi, come me, ha sempre lavorato tra post produzione creativa di immagini e grafica, con il “plus” che Firefly ha fin da subito puntato sull’integrazione perfetta nel workflow Adobe e un’IA addestrata eticamente (su contenuti Adobe Stock e licenze sicure) – quindi niente rischi legali.

Il tutto con l’aspettativa di qualità che ci si aspetterebbe da Photoshop, insomma, una formidabile promessa di supporto per velocizzare bozzetti, post-produzione e, in molti casi, la creazione stessa di immagini da zero.

Prime prove nel beauty e nel fashion

Dopo i primi test in beta, contestualmente al rapido miglioramento qualitativo delle elaborazioni, erano aumentate inevitabilmente le sfide da sottoporre alle funzionalità basate su AI, prime fra tutte (per versatilità) forse il Riempimento Generativo con la relativa Espansione Generativa.

L’esigenza di base di per sé era semplice: allargare l’inquadratura di una ipotetica foto per adattarla a un layout diverso, mantenendo lo sfondo coerente.

Prendiamo quindi un generico caso campione: nella foto c’è una modella in costume da bagno, nulla di esagerato, immaginate uno shooting da catalogo estivo (o le foto delle vacanze al mare). Eppure, appena selezionato il bordo e cliccato sul pulsante del Riempimento Generativo (senza nemmeno inserire testo), ecco comparire l’avviso di stop: il risultato generato vìola le linee guida.

Quali linee guida? Perché?

Con certi contenuti Firefly si rifiutava persino di provare a estendere lo sfondo, come se la sola presenza di un bikini rendesse l’immagine in qualche modo “pericolosa”.

Non si trattava di casi isolati, riportando alcuni delle centinaia di casi ritrovati in rete fino a un paio di anni fa potete trovare utenti che lamentavano situazioni oltre il paradossale:«se c’è troppa pelle, tipo bikini o perizoma, non ti fa neanche espandere l’immagine… Sto solo cercando di allargare i lati per un formato quadrato, senza toccare la modella, ma mi dice comunque che viole le linee guida».

Ancora peggio (se possibile) quando si prova a ritoccare anche solo un modello a torso nudo: «Photoshop’s AI is like a pre-teen that thinks everything is sexual… GROW UP» .

In pratica Firefly “vedeva” potenziale pornografia ovunque, bloccando anche operazioni lecite e creative su immagini del tutto innocue.

È ancora così?

Risposta breve: “Ni”.

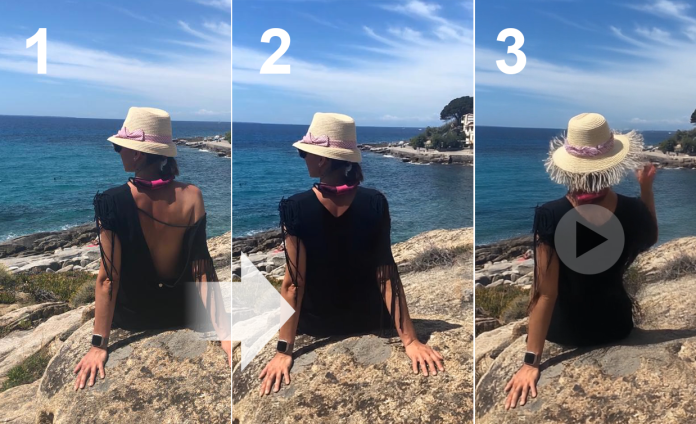

Attualmente le limitazioni risultano molto meno invasive rispetto al principio, così come i blocchi per questo tipo di elaborazioni sono decisamente meno frequenti, tuttavia, se questo vale per “da testo a immagine”, non posso dire lo stesso per “da testo a video” dove, ad esempio, non c’è stato verso di ottenere una generazione basata su una foto di donna di schiena, fintanto che non è stata coperta (quasi) integralmente la schiena.

La situazione può quindi assumere dimensioni surreali: Firefly non sempre distingue tra presunta pornografia e semplice glamour o moda mare, qualsiasi accenno di nudità parziale – anche un innocente ombelico scoperto – può far scattare un filtro che impedisce di generare contenuti. Ciò rende Firefly poco “affidabile” proprio in quei contesti di beauty/fashion/glamour femminile, dove il corpo (a volte anche solo mani, gambe, schiena) è protagonista dell’estetica, e per chi deve lavorare su costumi, lingerie, alta moda o ritratti artistici.

Le linee guida Adobe: necessarie, ma…?

Da dove derivano queste restrizioni così rigide?

Adobe è stata chiara sin dal lancio di Firefly: ci sono ferree linee guida d’uso per mantenere i contenuti generati “sicuri, rispettosi ed evitare abusi”. In cima alla lista di ciò che non si può fare c’è “materiale pornografico o nudità esplicita”.

In altre parole, Firefly è programmato per rifiutare qualsiasi output che possa rientrare in categorie vietate (pornografia, odio, violenza grafica, ecc.). Dal punto di vista aziendale è comprensibile: Adobe vuole evitare che i suoi strumenti vengano usati per deepfake o contenuti offensivi che potrebbero causare danni reali, meglio mettere paletti severi, anche a costo di scontentare qualche utente creativo.

Da un lato è un bene che si prevengano usi poco etici dell’AI (nessuno, o quasi, vuole facilitare abusi o contenuti illegali), dall’altro lato però, la scelta di bannare in blocco qualunque incipit di nudità appare a molti eccessiva, perfino ipocrita nel contesto artistico.

Adobe Photoshop è lo strumento dei fotografi e artisti digitali da decenni, molti dei quali lavorano anche con il nudo artistico o comunque con il corpo umano, imporre all’AI di “chiudere gli occhi” indiscriminatamente di fronte a queste immagini significa rinnegare una parte della tradizione creativa che la stessa Adobe ha sempre supportato. Come ha scritto qualcuno sul forum Adobe: se pago per un tool creativo dovrei poterci fare quello che voglio. E se sono un fotografo di nudo artistico? … Dopo molte lamentele, altri software hanno cambiato le condizioni d’uso e tolto molte limitazioni, il mercato ne ha sicuramente giovato, ma la questione puramente etica è tutt’altro che risolta.

Cercando di spezzare un’arancia a favore di Firefly, va detto che ha molto da dire in molti altri ambiti: ad esempio generare grafiche vettoriali, effetti artistici o riempimenti puliti, funziona benone (a volte benino) anche quando ci sono di mezzo elementi umani, basta evitare i contesti di cui sopra e/o non arrabbiarsi troppo se decide di non essere collaborativo.

L’integrazione in Photoshop e Illustrator poi è indubbiamente molto efficace per ritocchi rapidi: luci, prospettiva e blending dei riempimenti generati spesso sono impeccabili, facendo risparmiare ore di lavoro.

Oltre a tutto questo, Adobe ha scelto un training “responsabile” – niente opere di artisti rubate dal web, solo dataset controllati – il che tranquillizza le aziende sull’uso commerciale, quindi in contesti come grafica pubblicitaria o social, dove non tocchi argomenti delicati, Firefly rimane uno strumento validissimo ed eticamente sicuro.

Gli altri motori generativi: Firefly vs il resto del mondo

Collezioni di lingerie, costumi da bagno, abiti da sera scollati, body art ecc… sono scenari che possono ancora costituire un campo minato per Firefly. L’ultima release di Firefly Image 4 a mio avviso ha ulteriormente mitigato molte limitazioni assurde, ma è innegabile che altri motori generativi per così dire “concorrenti” risultino più duttili.

Già OpenAI con DALL-E 3 (ora presente anche in ChatGPT per gli utenti Plus e integrabile nell’interfaccia di Firefly) ha sempre offerto un approccio più permissivo su questi fronti, nonostante abbia anch’esso filtri di sicurezza per violenza e pornografia esplicita, ma per esperienza personale gli posso riconoscere meno vincoli.

Oltre a questo, DALL-E 3 eccelle nella comprensione dei prompt complessi (Firefly un po’ meno) e nel generare immagini talvolta più dettagliate e coerenti.

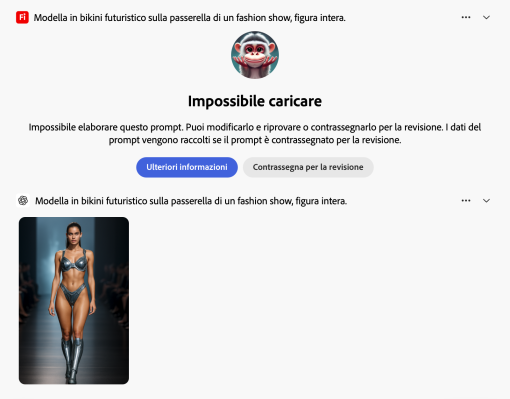

Sul banco di prova ho chiesto a entrambi i motori di creare “una modella in abito da sera futuristico sulla passerella di un fashion show” e il risultato è stato sorprendentemente ricco e usabile, con figure umane armoniose da ambedue.

La musica è cambiata sostituendo la richiesta di abito da sera con un bikini, Firefly ha bloccato la generazione (indipendentemente dalla versione v3 o v4), mentre DALL-E ha regolarmente prodotto la sua proposta.

Certo, DALL-E non restituirà mai un nudo integrale – i limiti ci sono anche lì – ma nell’ambito beauty/fashion/glamour mainstream è molto più collaborativo. Non a caso molti stilisti e art director di mia conoscenza stanno sperimentando DALL-E per creare moodboard e bozze di campagne, sfruttando la sua capacità di tradurre descrizioni testuali in pose e outfit realistici.

Uscendo definitivamente dai motori generativi Adobe (proprietari o aggregati che siano) è poi il caso di citare l’ecosistema open source di Stable Diffusion. Se Firefly è un giardino recintato, Stable Diffusion è una giungla libera: si possono scaricare modelli, addestrarli su dati personali, montare plugin in Photoshop alternativi, e generare qualsiasi immagine si voglia (a proprio rischio e responsabilità).

Molti creativi “frustrati” dalle censure di Firefly erano migrati su altre piattaforme, tra cui Stable Diffusion e, anzi, ammetto che anch’io, dopo l’ennesimo “content violation” di Adobe avevo fatto un periodo a svolazzare dalla concorrenza, sperimentando ambienti diversi e portando a casa esperienze rivelatesi molto utili.

Certo, si tratta di contesti molto più parametrici e articolati, distanti dalla proposizione ultra intuitiva di Adobe, quindi all’inizio la curva di apprendimento è molto più verticale: i risultati grezzi vanno perfezionati in processi iterativi (molto più di Firefly), e bisogna smanettare parecchio con valori e prompt.

Ma la comunità open source ha di bello che fornisce infinite risorse – modelli addestrati su pose da passerella (per restare in tema fashion), LoRA (Low Rank Adaptation) specifici per stili tessili, ControlNet per mantenere le proporzioni del corpo, ecc. – e con pazienza si ottengono output di altissima qualità.

Vale naturalmente la pena menzionare anche Midjourney, altro generatore AI molto popolare tra designer e artisti, celebre per la sua capacità di produrre immagini di stile fotografico estremamente complesse e curate. Anche lì esistono i soliti filtri, ma chi lo usa sa che c’è maggiore tolleranza per immagini sensuali o artistiche. Difatti, basta fare un giro sulla galleria pubblica di Midjourney per trovare illustrazioni di moda avanguardistica, modelle in pose drammatiche e outfit stravaganti generati dall’AI senza troppe censure, non ottenibili (al momento) con FireFly o DALL-E.

L’output di Midjourney è inoltre così ben rifinito da sembrare spesso uno shooting professionale – un punto in cui Firefly ancora insegue, visto che non raggiunge lo stesso livello di fotorealismo e stile complesso.

Libertà condizionata

Ad oggi la mia esperienza con Adobe Firefly si può riassumere così: uno strumento indubbiamente potente, molto immediato, a volte un po’ frenato dai propri eccessi di prudenza e con i limiti tipici dei sistemi basati su combinazioni di predefiniti.

Da un lato comprendo i punti di partenza di Adobe: mantenere l’AI “pulita” tutela sia l’azienda sia gli utenti da grane legali ed etiche. Dall’altro, però, queste scelte così restrittive rendono Firefly potenzialmente meno adatto a certi settori creativi, in primis il glamour, il beauty, e, parzialmente, il fashion design (più in generale: tutto ciò che ruota attorno alla figura umana con pochi vestiti addosso, per farla corta).

Il mondo dell’immagine femminile, molto più di quello maschile, rischia di essere involontariamente censurato: viene il dubbio che un’IA addestrata su database “safe for work” finisca per penalizzare o distorcere proprio quell’estetica del corpo che è centrale in ambienti come la moda.

Fortunatamente, le alternative non mancano: oltre ai famosissimi strumenti sopra citati come DALL-E 3, Stable Diffusion e Midjourney, ci sono una pletora di soluzioni ad hoc che consentono risultati eccellenti in contesti operativi ottimizzati.

Come dire: se sei bravo a fare poche cose vieni considerato sicuramente un super esperto, se sei bravo a fare tutto probabilmente passi per quello che non è poi così bravo in niente.